¿Conoces Whisper? Se trata de una herramienta para transcribir textos de entrevistas o videos impulsada con Inteligencia Artificial, pero aunque suena a una gran idea, parece que se anda comportando medio raro. La acusan de inventar cosas que nadie dijo… Y de forma no muy amable.

Pues resulta que de acuerdo con distintos ingenieros de software, desarrolladores e investigadores académicos, citados por Los Angeles Times, Whisper suele inventar frases que nunca se dijeron al momento de hacer sus transcripciones. A eso ya hasta se le empezó a definir como “alucinaciones” que sufre la IA.

Esto es, en lugar de solo transcribir lo que ‘escucha’, Whisper pone frases o fragmentos enteros que se inventó. Y deja tú que ponga cosas que nadie dijo, el problema es que eso que inventa a veces es racista, violento o peligroso.

Racista por transcribir frases como “Niñas y una dama que eran negras” cuando el audio solo decía “dos niñas y una dama”; violento por decir que un niño tenía “un cuchillo terrorista” cuando la grabación solo mencionaba a un niño con un paraguas; y peligroso porque a veces inventa tratamientos médicos que nadie recetó cuando se usa en hospitales.

Checa el dato: Un investigador de la Universidad de Michigan se topó con alucinaciones en 8 de cada 10 transcripciones de la IA; un ingeniero en 5 de cada 10 y se encontraron 187 textos inventados en 13 mil pruebas.

El mismo reportaje de Los Angeles Times cita algunos ejemplos donde resulta muy severo que Whisper tenga sus alucines. Como ya mencionamos, es muy utilizada en hospitales, como cuando se transcriben consultas médicas. La IA puede transcribir tratamientos equivocados, además de diagnósticos erróneos, lo que en casos extremos podría costarle la vida a alguien.

Otro riesgo importante es que esta herramienta también se usa para ayudar a personas con problemas parciales o totales de audición. Entonces imagínate tú que alguien así ocupa que le transcriban un audio importante y Whisper salga con alguna alucinación. Podría ser peligroso o de plano no servir de nada, ya que esas personas no tendrían manera de distinguir la parte inventada y creerían que la transcripción es fiel y correcta.

En resumen, y parafraseando a William Saunders (investigador de San Francisco), el problema es ofrecer y hacer accesible un producto como Whisper en el que la gente confiará y lo integrará a sus actividades con todo y su terrible falla. ¿Qué tanta gente confía en esta IA? Pues nada más tuvo 4.2 millones de descargas solo en octubre (saca tus cuentas de en cuántos errores y en cuántas industrias se traduce eso).

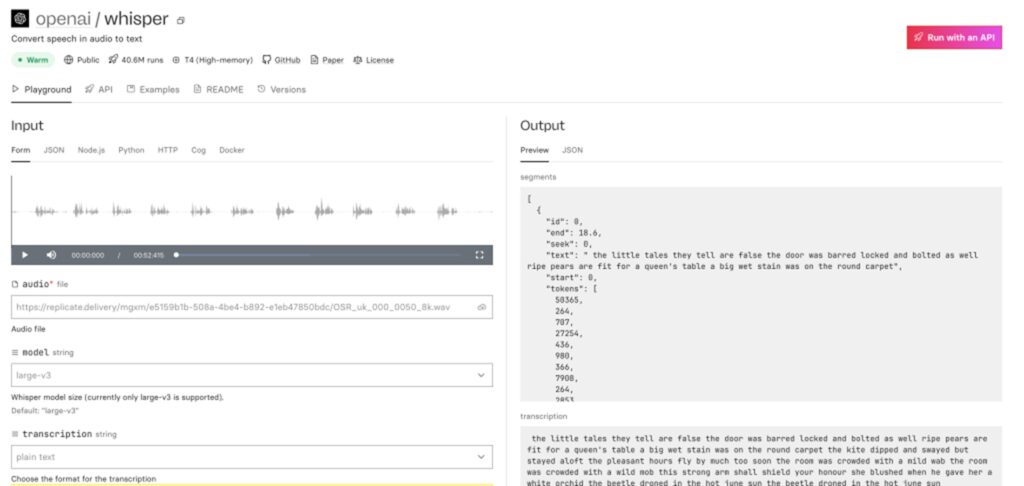

Cabe mencionar, ya para finalizar, que Whisper es una IA de OpenAI (la misma detrás de ChatGPT), la cual la describe como un “sistema de reconocimiento automático del habla que permite la transcripción en varios idiomas, así como la traducción de esos idiomas al inglés”.

Funciona mediante una arquitectura de extremo a extremo, donde uno codifica el audio y otro lo decodifica. El audio que ‘escucha’ se divide en fragmentos de 30 segundos y se convierte en un espectrograma que pasa a un codificador. Luego pasa al decodificador que lo convierte en texto tras identificar el idioma y el habla que se emplea.